一、机器学习基本概念与定理 #

1.1 基本概念 #

1.2 常用定理 #

1.3 数学基础 #

1.4 神经网络发展历史 #

第一次浪潮:

第二个迅猛发展:算法突破与架构创新

第三次浪潮:深度学习崛起与架构革命

第四次浪潮:大模型时代与多模态融合

二、人工神经网络(ANN) #

2.1 定义: #

- 神经网络是由具有适应性的简单单元组成的广泛并行互联的网络,它的 组织能够模拟生物神经系统对真实世界物体所作出的反应。

- 神经网络是由简单处理单元构成的大规模并行分布式处理器,天然地具 有存储经验知识和使之可用的特性。

2.2 生物神经元模型: #

兴奋型与抑制型(excitatory/inhibitory):依膜电位阈值而定

可塑性:突触传递特性可变,强弱正负皆可调---学习记忆之基石

时空整合性

时间整合:不同时段的神经冲动于同一突触汇聚

空间整合:同时段不同突触的膜电位协同整合

2.3 人工神经元 #

2.3.1 人工神经元结构 #

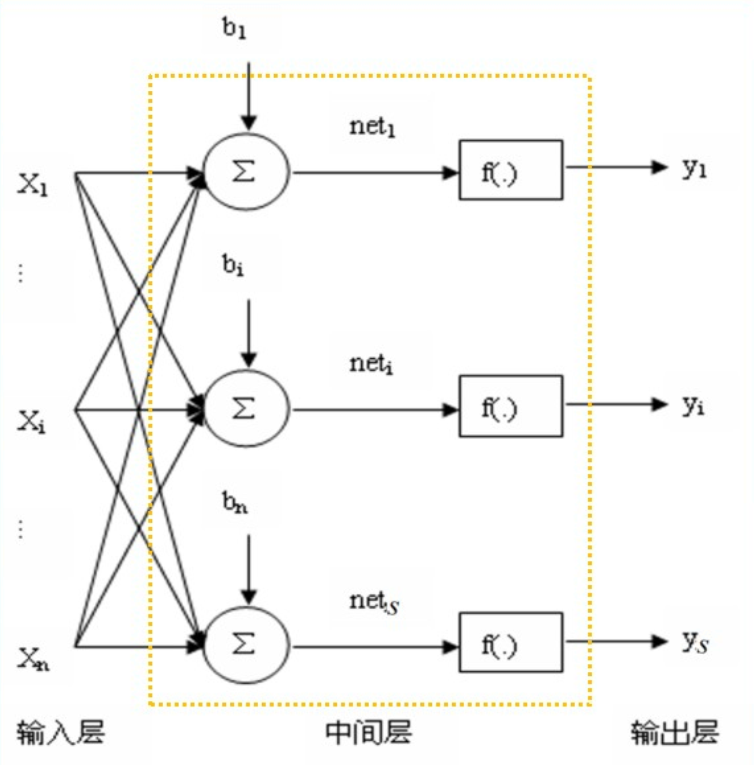

根据生物神经元抽象出人工神经元模型,基本结构:加权求和+非线性激励,即

累加器输出:$net_t=\sum^N_{j=1}\omega_{ij}+b_i$

网络输出:$y_i=f(net_t)$

其中,$w_{ij}$为输入的权值,$b_i$为偏置。

以上就是一个简单的单层感知机,具体参考单层感知机的介绍。

神经网络最核心的问题就是求网络的权值,方法是通过学习和训练。

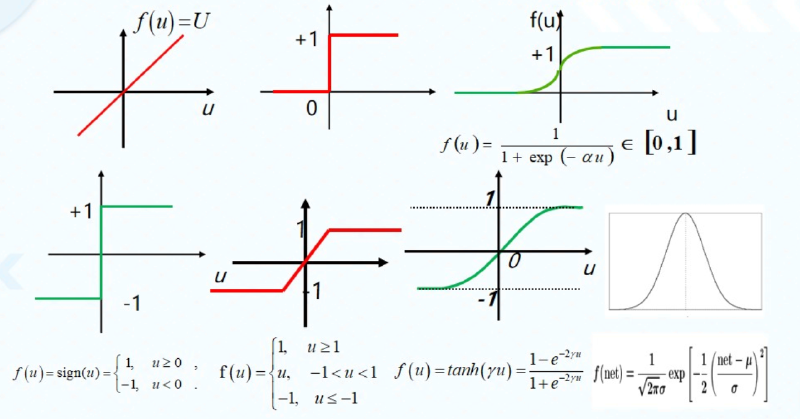

激活函数的选取$f(\cdot)$的选取模拟了神经元的整合能力,提供了网络的非线性建模能力,常用的有

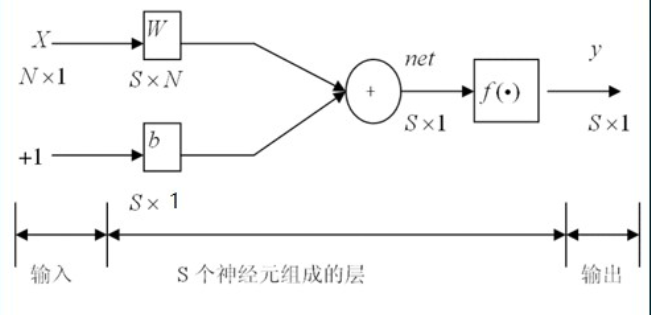

2.3.2 人工神经网络的数学描述 #

$net=W\cdot x+b, Y=f(net)=f(Wx+b)$,其中

用矩阵形式层级图表示为

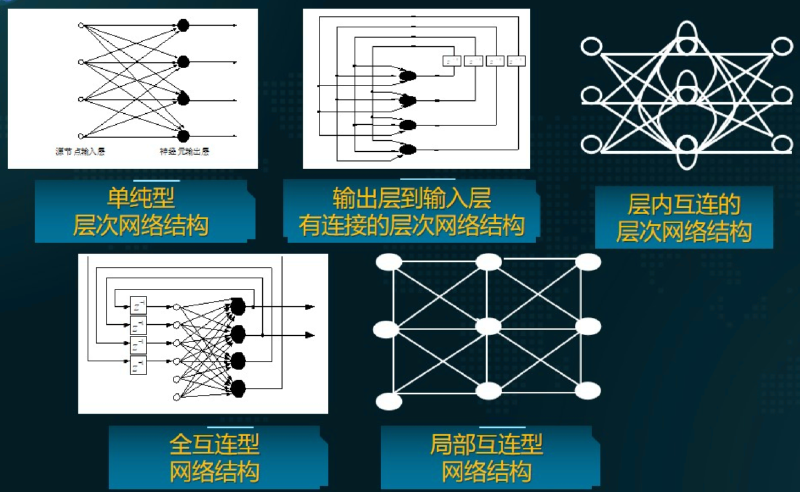

有了基本的人工神经元模型,可以构建出不同类型的人工神经网络,

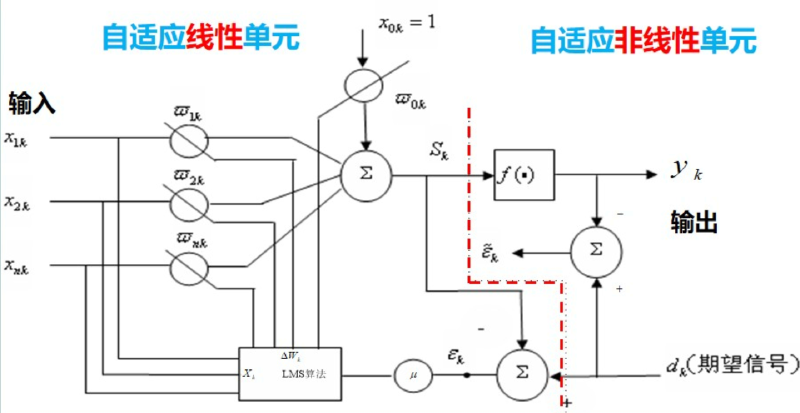

三、基于自适应信号处理(ASP)的人工神经网络 #

LMS算法:即最小均方算法(Least Mean Square),是一种最陡算法的改进算法,该算法不需要已知输入信号和期望信号的统计特征,“当前时刻”的权系数是通过“上—时刻”权系统+—个负均方误差梯度的比例项求得。

新的权值$w_{k+1}=w_k+\mu\cdot(-\nabla_k)$

$\mu$是迭代步长/学习率,$\nabla_k=\frac{\partial MSE}{\partial w_k}$是梯度,带入MSE,得$\nabla_k=\frac{\partial}{\partial w_k}E(\epsilon^2_k)$

工程上常用瞬时功率${\epsilon_k}^2$代替平均功率$E({\epsilon_k}^2)$,即

$MSE=E({\epsilon_k}^2)\approx{\epsilon_k}^2$